AI 芯片厂商 Cerebras 部署 DeepSeek 服务爆单,降低成本反而扩大市场容量

发布时间:

据ZDNET 2月10日报道,AI芯片厂商Cerebras的CEO Andrew Feldman接受采访时说,该公司已经被运行DeepSeek-R1大语言模型的订单压垮。

据IT之家此前报道,Cerebras曾推出用于AI的晶圆级芯片,一块芯片就提供125 PFLOPS的峰值算力,搭配片外内存可以实现至高1.2PB的内存容量。

DeepSeek-R1的预训练成本可以低到GPTo1等主流模型的十分之一,且效果相近甚至更好,被一些人认为是AI的分水岭。

Feldman认为,DeepSeek对人工智能的影响不仅在当下,更在于将刺激出更大的AI系统。随着成本的降低,市场正在变得越来越大。

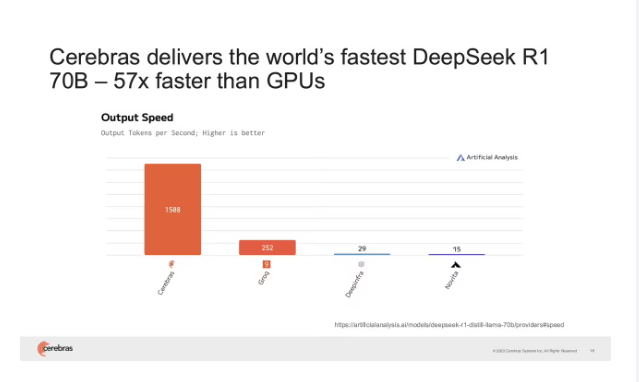

Cerebras在官网展示,Cerebras的晶圆级AI芯片,部署DeepSeek-R1 70B可以达到1508 tokens/s的性能,比GPU快很多。

用户在使用包括DeepSeek-R1等“推理模型”时,输入提示词后需要时间等待是一大痛点。因为采用了名为Chain-of-thought(CoT)的方法来增强模型的推理能力,将多步问题分解为中间步骤,允许模型在需要时执行额外的计算。推理时逐字进行推理,对整段提示词的推理需要进行多次,需要大量算力。

客户可以通过蒸馏将大模型的“知识”转移到小模型来缓解痛点,大模型通常被称为教师模型,较小的模型被称为学生模型。

为了改善使用DeepSeek模型的体验,Cerebras为客户提供的标准做法是利用DeepSeek开源在Hugging Face的模型参数(权重)作为教师模型,蒸馏出一个较小的学生模型用于实际部署,Cerebras在官网表示DeepSeek R1蒸馏到Llama 70B后精度几乎没有下降。

Feldman表示,DeepSeek是第一个顶级的开源推理模型,是开源AI的重大胜利。通过蒸馏技术,开源模型只需要公开模型参数(权重),研究人员不需要访问源码也可以复制新AI模型的进步。他认为,DeepSeek的经济性不仅震惊整个人工智能行业,更可以使尖端AI芯片和网络技术获得更多投资。

有些人认为计算成本的下降将导致市场萎缩,但过去50年都表现出降低成本反而扩大市场容量。无论是电脑还是智能手机,价格的降低都推动了普及。

Cerebras从去年8月开始提供公共推理服务,自称是“世界上最快的人工智能推理服务提供商”。该公司目前只提供蒸馏后的70B模型,Feldman表示,405B的模型太贵了,客户更青睐价格实惠的模型,当然也有一部分客户认为准确性的提升值得更高的成本而选择更大的模型。